Технологии хранения данных совершенствуются постоянно. А иначе нельзя, поскольку объемы информации растут и темпы их прироста и не думают падать. Скорее даже наоборот. Появляется потребность в хранении новых типов данных, таких как оцифрованные звук, фото и видео. Росту объемов способствует внедрение систем автоматизации бизнеса — ERP, CRM, SCM, Business Intelligence (BI). Появляются и требования контролирующих органов хранить информацию более продолжительное время. Причем совершенствование не сводится только лишь к росту быстродействия и объемов накопителей, к повышению пропускной способности интерфейсов передачи данных или появлению новой функциональности в программных средствах управления комплексами систем хранения данных (СХД) и систем резервного копирования. Не менее важно и то, что в последнее время идет переход от управления данными к управлению информацией, что нередко обуславливает существенные изменения в подходах к работе информационных систем и ЦОДов, которые такое управление и осуществляют. А именно к этому сводится столь популярная ныне концепция ILM. Другим направлением является триада виртуализация/консолидация/автоматизация, которая не так давно преодолела период спада, вызванного разочарованием первыми не слишком удачными решениями. Эти два направления, по мнению IDC, и являются магистральными в эволюции систем хранения данных. Тем более, что часто внедрение одного невозможно без реализации другого, так что это дороги в одну сторону.

От HSM к ILM

Лавинообразный рост объемов данных, о котором так много говорят, начался далеко не вчера. Этой проблеме уже почти полвека. Так что с того момента, когда началось массовое использование вычислительной техники, возникла задача перераспределения объемов информации между разными классами носителей, причем сделать это нужно было так, чтобы соблюсти баланс между быстродействием всей системы и стоимостью решения.

В результате еще около тридцати лет назад IBM на своих мэйнфреймах реализовала концепцию HSM (Hierarchical Storage Management, иерархическое управление носителями). Надо сказать, эту аббревиатуру можно встретить до сих пор, и не так уж и редко. Ключевым положением этого понятия является перемещение данных между носителями более быстрыми и дорогими, такими как дисковые массивы, и более медленными, но при этом дешевыми ленточными накопителями или оптическими дисками. Позднее этот подход мигрировал сначала на мини-машины, затем на Unix-серверы, а потом и на оборудование стандартной архитектуры. Обычно часто используемые данные хранятся на быстродействующих дисковых массивах. А те, что не требуются длительное время, перемещаются в более медленную часть системы. Когда запрашивается файл, находящийся на магнитной ленте, он вновь переписывается на дисковый массив. В результате общий объем доступных данных может существенно превышать объем быстрых носителей, но большинство пользователей все равно не заметит падения скорости, так как на более медленных устройствах находятся редко запрашиваемые данные. Ведь согласно эмпирической информации 90% обращений относится лишь к 10% данных.

Со временем эта система менялась. Переставали применяться носители, выходившие из употребления. С появлением более дешевых, но при этом менее быстрых дисковых массивов системы усложнялись. Дешевые диски стали промежуточным звеном на пути данных от высокоскоростных систем хранения к ленточным накопителям. В последнее время эту роль играют также виртуальные ленточные библиотеки.

Элементы HSM так или иначе присутствуют практически во всех комплексах хранения данных, даже начального уровня. К примеру, уже в клиентской версии такого популярного продукта, как Symantec NetBackup, можно задавать несколько настраиваемых политик резервирования для разных типов данных. Естественно, продукты, ориентированные на серверное использование, еще более функциональны. Кстати, именно то, что касается внедрения элементов HSM (и, забегая вперед, ILM тоже) является наиболее ярким примером тому, как подходы, ранее использовавшиеся только в системах высокого класса, перемещаются в массовый сегмент среднего и даже начального уровня.

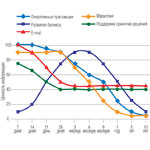

Вместе с тем разная информация из тех или иных корпоративных информационных систем востребована тоже по-разному (рис. 1). Плюс ко всему часть данных со временем превращается в ссылочные. Это происходит тогда, когда прекращается их модификация, но они всё ещё используются, например, для создания отчетов. Такими данными оперируют и системы BI. Сюда же стоит отнести информацию, которая должна храниться определенное время в соответствии с требованиями различных нормативных актов. Эти данные приходится хранить вместе с оперативными, которые продолжают модифицироваться, в результате чего растет стоимость хранения и возникают сложности с соблюдением нормативов. Проблемой становится и своевременное удаление устаревших данных.

Ответом на это стало появление концепции ILM (Information Life Сycle Management, управление жизненным циклом информации). По определению SNIA (Storage Networking Industry Association, Ассоциация производителей сетевых устройств хранения данных, www.snia.org), ILM — это набор политик, процессов, практик, сервисов и инструментов, используемых для того, чтобы соотнести ценность информации с точки зрения бизнеса с наиболее подходящей и эффективной по стоимости инфраструктурой, начиная с момента создания информации и заканчивая ее размещением.

В принципе ILM является дальнейшим качественным развитием HSM, переходом от управления данными к управлению информацией. При этом используются методики и решения, давно применяемые в системах управления документооборотом, многие из которых восходят еще к доэлектронной эре. Сейчас же понятие документа трактуется более широко, так как все более значимую роль в бизнесе начинают играть самые разнообразные формы контента — медиафайлы, электронная почта, часть корпоративного или общедоступного Web-контента. Ввиду их важности все эти информационные компоненты фактически приравниваются к документам, и таким образом в ряде случаев системы документооборота вытесняются системами контент-менеджмента. Кстати, далеко не случайно, что ILM начали продвигать EMC и IBM, у которых системы контент-менеджмента являются частью бизнеса. Это даже дает повод для такого суждения, будто бы все разговоры об ILM — лишняя возможность для вендоров перевести стрелки на программные решения и сохранить таким образом рентабельность, показатели которой от продажи исключительно аппаратных средств из года в год падают. Тем не менее те же самые критики признают, что в основе этих идей лежат вполне здравые подходы, действительно позволяющие навести порядок в больших массивах данных, которые генерируют корпоративные информационные системы, и снизить затраты на их хранение.

В рамках ILM предлагается классифицировать бизнес-информацию компании, прежде чем она попадет в инфраструктуру хранения. С точки зрения данных файл с текстом детективного романа, загруженный из электронной библиотеки, и контракт на многомиллионную сумму абсолютно равнозначны, но с точки зрения информации первый, что вполне естественно, не несет никакой ценности для компании. Для классификации требуется выработка показателей уровня сервиса (или SLА в английской аббревиатуре) и политик, на основании которых будет идти управление информацией. Основой для их формирования являются бизнес-процессы компании и требования нормативных актов. Согласно этим политикам и происходит перемещение информации между разными элементами системы хранения, в результате чего наиболее востребованные данные хранятся в высокопроизводительных системах, а менее критичные попадают в дешевые хранилища. Кроме того, устраняется дублирование данных, потому что оперативным и ссылочным соответствуют разные SLA. В результате обработка информации ведётся по схеме, представленной на рис. 2.

Для внедрения ILM согласно методологии SNIA необходимо пройти пять фаз:

- консолидация данных и сети хранения;

- стандартизация данных и сервисов хранения;

- создание «островков» ILM и фокусирование на отдельных корпоративных приложениях;

- введение автоматизации в процесс управления размещением данных;

- объединение «островков» в единую среду.

На их основе каждым вендором разработаны свои методики, которые могут иметь заметные различия. Например, EMC предлагает всего три последовательных этапа в создании ILM-инфраструктуры: создание ярусной инфраструктуры хранения, применение ILM-подходов к одному из ключевых приложений и наконец интеграция всех приложений в одну инфраструктуру. Довольно подробно этот процесс был описан в статье «Погружение в ILM» Алексея Назарбаева (см. IE, № 18/2006, стр. 31).

Вместе с тем внедрение ILM пока еще остается уделом крупных компаний. Мелкие и средние заказчики просто не располагают необходимыми материальными ресурсами для внедрения таких подходов, что признают и вендоры. Например, IBM не рекомендует внедрять свои ILM-решения на небольших предприятиях. При этом компании сектора SMB вынуждены подчиняться тем же правилам, что и крупные. В результате, согласно данным последнего исследования GlassHouse Technologies, для SMB-предприятий внедрение концепций ILM все чаще становится приоритетным, пусть даже и не полностью или в неканоническом виде. Для этого даже ввели отдельную аббревиатуру DLM (Data Lifecycle Management, управление жизненным циклом данных).

Виртуализация, консолидация, автоматизация

Виртуализация и все, что с ней связано, в последнее время также является весьма «модной» темой. В том числе и виртуализация систем хранения. Тем более, что использование такого рода средств существенно упрощает внедрение элементов ILM. Согласно определению Meta Group, ILM является процессом, в рамках которого информация с минимальными издержками перемещается по средам хранения соответственно ее содержанию и бизнес-требованиям. Для успешного решения этой задачи, особенно второй ее части, вся триада (виртуализация/консолидация/автоматизация) применительно к системам хранения приобретает просто огромное значение. Иначе успешного внедрения в более-менее сложной системе добиться невозможно. Интересно отметить, что виртуализация систем хранения служит наглядной иллюстрацией того, что новое является хорошо забытым старым. Впервые термин Virtual Storage появился еще в конце 50-х годов. Тогда он означал расширение системной памяти за счет более дешевой дисковой. Это используется и сейчас, типичные примеры тому — файл подкачки Windows или раздел подкачки Unix-подобных систем. Затем появилась виртуализация на уровне сервера, когда одному логическому тому может соответствовать несколько физических устройств. Следующим шагом стала виртуализация на уровне систем хранения — в этом случае дисковое пространство СХД для пользователей локальной сети преобразуется в локальные тома, без физической привязки к реальным дискам. Но для этого решения требуется полная однородность сети и системы хранения.

В новом качестве о виртуализации систем хранения заговорили на рубеже нового века, когда появились полноценные сети хранения данных, или SAN (storage area network). Кроме того, как раз тогда назрел кризис: стало ясно, что дисковое пространство систем хранения и серверов используется крайне неэффективно. Плюс ко всему виртуализация решала еще и задачу консолидации разнородных ресурсов, преодолевая барьеры между несовместимыми между собой проприетарными технологиями. А это не редкость и в тех случаях, когда приобретается оборудование одной марки, но фактически произведенное разными компаниями в рамках ODM-контрактов. Также достигается существенная экономия на лицензировании ПО за счет того, что множество разрозненных систем объединяются в одну, пусть и виртуальную. Ну и наконец существенно упрощается управление всем этим хозяйством и его администрирование, в том числе за счет использования средств автоматизации.

Но путь таких продуктов до потребителя оказался довольно трудным. Техническая зрелость самых первых решений для виртуализации систем хранения, появившихся на рубеже 90‑х — 2000-х, оставляла желать много лучшего. Да, серверы и накопители, с одной стороны, и адаптеры, концентраторы, коммутаторы, с другой, к тому времени достигли необходимого уровня зрелости, но вот сами управляющие модули часто были еще очень «сырыми». Что, естественно, привело к разочарованию, и это еще мягко сказано. Вот прямая цитата из аналитического отчета по рынку систем хранения того времени: «Виртуализация систем хранения стала просто ругательным словом...

Первоначальный ажиотаж оставил после себя лишь разочарование. Произошедшее можно объяснить как незрелостью технологий, и, как следствие, неспособностью справляться с нагрузками корпоративных систем, так и тем, что производители не смогли соотнести решение задач виртуализации с реальными проблемами пользователей». К тому же решения для виртуализации часто предлагали совсем небольшие компании, которым корпоративный сектор просто не доверял.

Хотя некоторые из решений, появившиеся тогда, были хорошо приняты рынком. Это, например, виртуальные ленточные библиотеки, появление которых стало поводом для разговоров о скорой смерти накопителей на лентах. Но все же здравый смысл возобладал и стало ясно, что ленты — это крокодилы, а не динозавры. Не говоря уже о том, что виртуальные ленточные библиотеки великолепно дополняли физические, выступая в роли своего рода буфера при резервном копировании данных.

Но уже к 2005 году компании EMC, Hitachi Data Systems и IBM предложили новые решения, заложившие «вторую волну» виртуализации систем хранения. С технической точки зрения решения этих компаний между собой различались, и довольно существенно. Это было обусловлено применением разных подходов к аппаратным средствам виртуализации: с использованием специализированных управляющих модулей (appliance based в англоязычной литературе), включаемых в поток передачи данных (IBM); на уровне коммутаторов, или switch based (Hitachi); на уровне контроллеров, controller based (EMC). Сейчас в арсенале этих компаний, и не только их, присутствуют решения на базе разных подходов, иногда даже всех вышеперечисленных, поскольку каждый из них может быть хорош в одной нише и при этом плохо подходить для другой или просто быть неоптимальным как по причине излишней сложности и дороговизны, так и наоборот — вследствие отсутствия резервов по масштабированию. Хотя в начале процесса каждая компания «большой тройки» предлагала свой подход и никакой иной, в результате чего на рынке возникали заметные перекосы. Так, например, до 2005 года доминировали решения на базе специализированных модулей, которые просто раньше вышли на рынок, в то время как конкурирующим системам приходилось еще завоевывать свое место.

Но уже тот факт, что данные решения были предложены крупными корпорациями, за покупку продуктов которых еще никого не уволили, вполне естественно выводил такие программно-аппаратные комплексы на новое качество.

Плюс ко всему при всей непохожести решения эти объединяло то, что в них обеспечивается высокий уровень обратной связи между управляющим комплексом и самими накопителями. В целом средства виртуализации вне зависимости от поставщика позволяют решить следующие задачи:

- обеспечить разделение доступного пространства хранения на виртуальные тома независимо от физического размещения данных;

- консолидировать оборудование различных производителей в единую инфраструктуру;

- разделить оборудование на классы, например, исходя из производительности, доступности, объема и стоимости хранения данных;

- подключать дисковые массивы раннего поколения к современной системе, играющей роль платформы виртуализации. При этом для подключенных систем будут действовать все функции массива.

Вполне естественно, что всё это упрощало управление и администрирование, позволяя легко и быстро наращивать емкость и повышать эффективность использования имеющихся систем хранения. Кроме того, виртуализация лучше соответствует подходам ILM и упрощает переход к сервисно-ориентированной модели Utility Computing, которую активно поддерживает целый ряд вендоров и интеграторов. В основе ее заложена идея предоставления вычислительных ресурсов по принципу коммунальных услуг: использование ресурсов по мере необходимости с оплатой по факту и в объеме реально использованных услуг.