В последние годы много говорят о буме в области высокопроизводительных вычислений. Данный сегмент растет существенно быстрее рынка в целом. В результате уже каждый пятый процессор в мире используется в кластерах и суперкомпьютерах. И ничего удивительного в этом нет. Уже давно суперкомпьютеры — это не только уникальные изделия с заоблачной ценой. Да, есть и такие, но погоду на рынке сейчас делают не они. Основная часть суперкомпьютеров собирается из стандартных массовых, а следовательно, дешевых компонентов, которые многим по карману. Были бы задачи, которые необходимо более-менее регулярно решать… Россия здесь не является исключением. Лишним доказательством возрастающего практического интереса к этой области в нашей стране может служить и настоящий номер, где теме создания и использования вычислительных кластеров помимо данной статьи посвящены еще два материала. В мировой и российской практике создания и использования суперкомпьютеров много схожего, однако немало и различий. На основе рейтингов суперкомпьютеров — российского («Топ50. Суперкомпьютеры», www.supercomuters.ru) и общемирового («Top500 Supecromputing», www.top500.org), — а также интервью, которые наш журнал проводил с ИТ‑директорами компаний, установивших у себя подобные системы, мы попытались проанализировать схожести и различия и сделать некоторые прогнозы относительно перспектив использования высокопроизводительных вычислений в российских компаниях.

Для чего используются суперкомпьютеры

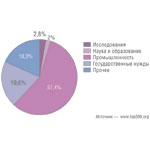

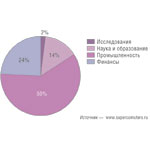

Прежде всего давайте проанализируем, для каких целей используются высокопроизводительные вычислительные системы в мире и в России. Здесь различия между нашей страной и всем остальным миром весьма и весьма существенны. Как можно видеть из рис. 1 и 2, даже сам перечень областей применения суперкомпьютеров у составителей российского и мирового рейтингов не полностью совпадает. В общемировом рейтинге не выделяют финансовую сферу, в то время как в российском отсутствуют системы, занятые вычислениями для государственных нужд. Впрочем, много зависит и от точки зрения. Например, системы, используемые Росгидрометом, можно с одинаковым успехом отнести как к области «государственные нужды», поскольку данные суперкомпьютеры эксплуатируются государственным ведомством, так и к сфере «исследования», если за точку отсчета брать решаемые задачи.

Да и распределение по областям применения далеко не одинаково. Если в мировом рейтинге более 57% всех систем используется в промышленности, то в России, Белоруссии и на Украине таких более чем вчетверо меньше — всего 14%. Зато в сфере образования и в фундаментальной науке ситуация обратная: в отечественном рейтинге доля используемых там систем 60%, что более чем втрое выше мировой.

Теперь посмотрим несколько подробнее на наиболее значимые области применения суперкомпьютеров.

Образование и наука

Явный перекос в сторону сферы образования и науки в России понятен и легко объясним. У нас серьезно начали заниматься высокопроизводительными вычислениями намного позже, чем в развитых странах. И это еще усугублялось острейшей проблемой кадрового дефицита. Так что строительство суперкомпьютеров в солидных вузах со сложившейся школой подготовки специалистов — шаг вполне здравый и логичный. Промышленность, финансовый сектор или государственные структуры могут создать сколько угодно систем для высокопроизводительных вычислений, но они окажутся бесполезными, так как их просто некому будет обслуживать. Не стоит забывать и о том, что вузы получают необходимое ПО бесплатно, в то время как коммерческие компании вынуждены за него платить, причем немало.

В результате практика сдачи вычислительных мощностей в аренду распространена среди научных и учебных учреждений весьма широко. (Надо сказать, что здесь мы идем в общем фарватере: за рубежом услуги аренды суперкомпьютеров тоже весьма распространены.) Так, например, кластер, запущенный в самом конце 2007 года в Уфимском государственном авиационно-техническом университете, помимо задач, связанных с обучением использованию высокопроизводительных вычислений при конструировании летательных аппаратов и их силовых установок, применяется для геофизических расчетов, прогнозирования уровня подтопления территорий и целого ряда задач, связанных с мониторингом экологической ситуации в Уфе и других населенных пунктах Башкирии. Задачи прогнозирования погоды и подтоплений решает и суперкомпьютер Томского университета. Целый ряд систем, расположенных в Москве, хотя бы время от времени используется для обсчета спецэффектов в кино и на телевидении. Ну а в таких разнопрофильных вузах, как МГУ, Томкий университет или МФТИ, даже без сдачи мощностей в аренду круг решаемых задач будет весьма разнообразным. Так что отсутствие статистики по распределению прикладных задач, решаемых с помощью систем из российского рейтинга, вполне объяснимо.

Скрывайся и таи

И у нас, и за рубежом компании далеко не всегда афишируют сам факт запуска высокопроизводительной вычислительной системы. Бывает и так, что ее просто не вносят в рейтинг, хотя информация о запуске системы может быть предана огласке. Вот это, кстати, очень трудно объяснить логически.

Отчасти это объясняется требованиями секретности, ведь одной из сфер применения высокопроизводительных вычислений, к примеру, является всё, что связано с разработкой и хранением ядерных боеприпасов. Создание новых материалов или аэрокосмических систем также нередко относится к разработкам если не чисто военного, то как минимум двойного назначения. Хотя и сугубо коммерческие компании не делают достоянием гласности факта приобретения или самостоятельного создания такого рода оборудования, чтобы не терять конкурентные преимущества.

Промышленность

Легко видеть, что промышленность — самый активный потребитель суперкомпьютеров в мире. И реальная доля их использования в этом секторе будет еще выше, если вспомнить, что необходимость в высокопроизводительных вычислениях может быть разовой. Например, известная компания Procter & Gamble не так давно прибегала к услугам IBM для расчёта формы чипсов Pringles с тем, чтобы при упаковке они попадали в тубы, а не в узлы упаковочных машин и не на пол цеха. К слову, RoadRunner — самый мощный на сегодняшний день суперкомпьютер — согласно контракту между IBM и Лос-Аламосской лабораторией будет применяться не только для моделирования процессов старения ядерных боеприпасов, но и для широчайшего спектра сугубо гражданских задач.

Однако в России промышленные компании явно не в авангарде суперкомпьютеростроения. Причина кроется в недооценке значимости НИОКР. Ведь на современном этапе высокопроизводительные вычисления — важнейшая часть данной работы. За это уже давно и правильно критикуют российский бизнес: доходы идут на потребление, но не на развитие продуктов и разработки.

Типичнейший пример — нефтегазовый сектор, который отнюдь нельзя упрекнуть в недостатке финансовых ресурсов. В отечественных нефтегазовых компаниях затраты на НИОКР на порядок ниже, чем в западных. Так, назывались данные, что «Газпром» на разведку новых месторождений тратит 60 млн. долл. в год, в то время как крупнейшие американские компании — не менее миллиарда каждая. В результате в российском рейтинге системы, которые занимались бы одними только геофизическими расчетами, просто отсутствуют. А ведь без этих расчетов невозможны ни разведка месторождений углеводородов, ни повышение продуктивности имеющихся скважин. Так что не удивительно, что в международном пространстве над такого рода задачами работает каждая десятая установка (см. таблицу). Причем среди них есть установки из первой десятки списка, в частности кластер, принадлежащий французской TOTAL. Хотя справедливости ради все же стоит отметить, что по меньшей мере на двух установках из отечественного Топ50 геофизические расчеты производятся, хотя эти задачи занимают весьма невысокий процент в их общей загрузке.

И тем не менее хочется быть оптимистом — во всяком случае и у нас уже начали осознавать, что без использования новейших средств моделирования просто невозможно разрабатывать конкурентоспособную продукцию. Наиболее яркий пример тому — компании, занятые производством авиационных двигателей. Без высокопроизводительных вычислений процесс разработки нового изделия будет занимать не менее двенадцати лет и потребует создания не менее пятидесяти опытных образцов. И полученный двигатель наверняка будет существенно уступать продукции конкурентов по таким важным показателям, как экономичность, уровень шума и безопасность эксплуатации. При использовании высокопроизводительных комплексов затраты времени, как показывает опыт, можно снизить в три-четыре раза, а количество опытных образцов — впятеро. Об опыте применения таких систем в НПО «Сатурн» рассказывается в одной из статей настоящего номера. Судя по некоторым высказываниям, и другие КБ, занятые разработкой сложной машиностроительной продукции, готовятся к запуску суперкомпьютеров.

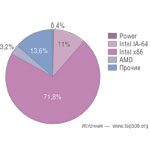

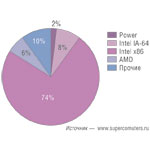

Из чего строят суперкомпьютеры

Теперь посмотрим, какие технологии применяются при построении суперкомпьютеров «у нас» и «у них». В вопросе выбора процессоров для построения высокопроизводительных вычислительных систем принципиальных расхождений между Россией и всем остальным миром нет (рис. 3 и 4). А те, которые есть, помимо статистической погрешности можно объяснить лишь тем, что у нас серьезно заниматься созданием суперкомпьютеров начали довольно поздно. В результате в отечественном рейтинге существенно меньше устаревших решений. К таковым можно отнести только одну систему — на базе HP PA-RISC. Зато в нем отсутствуют кластеры на базе 32‑разрядных Intel Xeon, которые в общемировом рейтинге пока еще имеются, но скоро тоже, видимо, сойдут на нет. Кроме того, из российского рейтинга уже больше года назад исчезли системы на базе SMP-архитектуры. А вот в общемировом они еще остаются, хотя их удельный вес ничтожен как в количественном отношении, так и в пересчете на производительность.

Общим моментом в обоих рейтингах является и тенденция к росту количества ядер. В них нет, например, систем, имеющих 64 процессорных ядра и менее. В остальном различия обусловлены только масштабами. Так, в мировом рейтинге системы менее чем с 1024 ядрами составляют лишь 2%, в то время как в российском на них приходится 72%.

Еще одна особенность: не так давно в российском рейтинге был довольно высок удельный вес самосборных систем, однако к настоящему времени ситуация практически полностью совпадает с мировой. В мировом Top500 такого рода системы еще остаются, но их удельный вес меньше процента. В последней редакции российского Топ50 самосборных систем вовсе не осталось. Впрочем, это можно объяснить и ужесточением подхода к тому, что считать самосбором. Раньше сюда относили системы, собранные самостоятельно из узлов некоего вендора, но теперь подобные работы без участия вендоров практически не проходят; следовательно, такую систему с полным правом можно «зачесть» этому вендору. В результате как в российском, так и в мировом рейтингах довольно высока доля HP и IBM в количественном выражении, поскольку именно их серверы служат строительным материалом при создании кластеров.

Несколько серьезнее различия в области архитектур, используемых при разработке высокопроизводительных вычислительных комплексов. У нас не столь популярны массивно-параллельные системы: в российском рейтинге они занимают всего 2% против почти 20% в общемировом. И появляться такие системы у нас начали совсем недавно, в то время как в общемировых рейтингах они присутствовали изначально. Это можно объяснить двумя причинами. Прежде всего до сих пор не преодолены стереотипы, связанные с тем, что построенные на такой архитектуре установки чрезвычайно дороги (как легендарные Cray). Немалую роль играет также бóльшая сложность разработки ПО для таких систем, что в наших условиях еще усугубляется значительным «кадровым голодом». Однако ситуация в российском сегменте показывает отчетливую тенденцию к сближению с общемировыми тенденциями, так что со временем доля таких систем скорее всего выровняется.

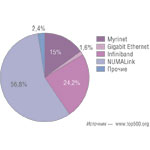

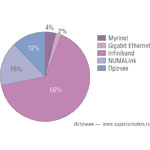

Что касается технологий построения коммуникационной сети, применяемых при создании суперкомпьютеров, то здесь отличия между нами и остальным миром весьма существенны (рис. 5 и 6). Так, у нас наибольшей популярностью пользуются Myrinet и Infiniband, в то время как доля Gigabit Ethernet намного ниже. За рубежом вполне типична ситуация, когда приходится выбирать Ethernet только потому, что уже есть соответствующая инфраструктура. У нас же руки создателей мощных вычислительных систем связаны куда меньше. Особенно в сфере науки и образования, где в основном и строятся высокопроизводительные вычислительные системы. Всё приходится создавать с чистого листа. В результате, что вполне естественно, выбираются более быстродействующие, надежные и лучше масштабируемые решения.

Кроме того, у нас существенно меньше доля всевозможных проприетарных сетевых технологий, которые на рис. 5 и 6 обозначены как «прочие». Это связано с меньшей востребованностью таких решений на нашем рынке, прежде всего вследствие их более высокой цены по сравнению с теми, что построены на открытых стандартах. Играют свою роль и экспортные ограничения на поставку оборудования, которое часто относят к продукции двойного назначения. Например, в США вычислительная техника производительностью выше определенного уровня может вывозиться за пределы страны только по разрешению госдепартамента, получение которого требует времени, иногда довольно продолжительного. Запуск системы, собранной из стандартных комплектующих, заведомо пройдёт быстрее, а решать на ней можно будет те же задачи, что и на системе с «громкой» маркой.

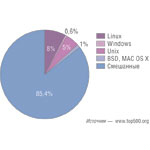

Что касается операционных систем, используемых на вычислительных кластерах, то здесь опять же принципиальной разницы нет. И хотя в российском рейтинге данные по используемым операционным системам не собираются (будем надеяться, что это временное явление), анализ открытой информации не дает значительных расхождений с данными, приведёнными на рис. 7. В России несколько ниже будет доля коммерческих Unix, BSD и смешанных систем, место которых займут ОС на ядре Linux. А вот системы Microsoft, несмотря на все усилия компании, погоды на этом рынке не делают. И у нас, и за рубежом их доля на грани статистической погрешности. Возможно, продукты из семейства Microsoft Windows и применяются в кластерах со смешанной программной средой, как, например, в системе, работающей в НИИ радио, но все равно их роль весьма и весьма ограниченна.

Трудности есть, но число проектов растет

Руслан Заединов

Руководитель направления центров обработки данных компании КРОКСегодня развитие российского сегмента рынка суперкомпьютеров сдерживается несколькими факторами. Один из них — кадровая проблема. В России пока недостаточно специалистов в области эксплуатации суперкомпьютеров и коммерческого программного обеспечения для научных и инженерных расчётов. Второй фактор — организационные трудности. Для эффективного использования суперкомпьютера многим российским предприятиям придется полностью перестроить работу над проектами в сфере проведения расчётов. Подобная перестройка всегда проходит медленно, сталкиваясь с проблемой человеческого фактора и устоявшихся с годами бизнес-процессов. Немало вопросов вызывает и цена ПО. В некоторых случаях стоимость коммерческой лицензии может превышать стоимость аппаратного обеспечения суперкомпьютера. Частично эту проблему можно снять, разработав собственные расчётные модули, но здесь снова возникает вопрос кадровой проблемы. Наконец, есть и такой фактор, как инфраструктурная проблема. Большой вычислительный комплекс вместе с инженерной инфраструктурой требует значительных электрических мощностей — от сотен киловатт до мегаватт. Не всякое предприятие способно выделить такие мощности. Но несмотря на все трудности всё больше российских компаний развивают платформы для высокопроизводительных вычислений. Яркими примерами тут могут служить наши проекты по построению самого мощного суперкомпьютера в промышленности России для НПО «Сатурн» и комплексной катастрофоустойчивой вычислительной инфраструктуры для Пермского моторостроительного комплекса.

Сложности проектов создания суперкомпьютеров

Наконец, попробуем проанализировать те препятствия, с которыми сталкиваются ИТ-директора, запустившие проекты по построению систем высокопроизводительных вычислений. Выпадающие на них трудности во многом универсальны и от страны не зависят. Более того, они, как правило, такие же, что и при строительстве центров обработки данных, предназначенных для поддержки бизнес-приложений. Выбор и подготовка помещения, выделение основного и резервного электропитания требуемой мощности, создание инженерной инфраструктуры (бесперебойное и резервное электропитание, охлаждение и кондиционирование, СКС) — задачи не такие простые, как кажется, причем далеко не только в России. Например, в Западной Европе, Китае или Индии проблемы с электропитанием стоят не менее остро. Хотя есть и определенная специфика. Если на Западе актуальнее проблема высоких цен на электроэнергию, то в Индии, Китае и во многих российских регионах речь идет о длительных сроках (или невозможности) подключения к электросетям, которые недостаточно развиты или сильно изношены.

Острой проблемой является подготовка помещений (этой теме мы даже посвятили отдельную колонку в этом номере). Действительно, помимо удаления коммуникаций приходится укреплять стены и перекрытия, иначе они просто рухнут под массой оборудования, часто превышающей тонну на квадратный метр, в то время как кирпич или природный камень способен выдержать лишь 800 кг/м2, а бетон и того меньше. О деревянных перекрытиях, которые тоже не редкость, и не только в России, можно и не говорить… При этом использование жидкостных систем охлаждения данные проблемы усугубляет еще больше, а воздушное далеко не всегда способно обеспечить теплоотвод от систем с высокой плотностью монтажа, например, с использованием блейд-решений.

Специфически российской проблемой является отсутствие стандартов на строительство ЦОДа вообще и его частного случая в виде суперкомпьютера. При этом, как говорят очень многие ИТ‑специалисты по обе стороны баррикад — и подрядчики, и заказчики, — европейские и американские стандарты у нас применимы далеко не всегда.

В России, как, впрочем, и на других развивающихся рынках, очень остро стоит проблема кадров. Это относится и к тем, кто имеет реальный опыт проектирования и строительства суперкомпьютеров. Такие специалисты, что называется, наперечет, и их расписание составлено на многие месяцы вперед. И если в том, что касается технической части, проблем меньше, то вопросы масштабирования проработаны очень плохо, и специалистов, способных это делать на высоком уровне, очень мало. (Например, при построении кластера в НПО «Сатурн» данную работу пришлось проводить в европейской лаборатории IBM. И это далеко не единичный случай.) Тем более, что заказчики далеко не всегда понимают, с каким объемом вычислений им придется столкнуться. В результате уже через относительно небольшое время созданный с таким трудом суперкомпьютер оказывается перегруженным. А при строительстве «с запасом», что в наших условиях более типично, тратятся лишние материальные ресурсы. Причем это относится не только к стоимости оборудования и ПО. Затраты на серверы, стойки, ПО и подготовку помещений для размещения кластера производительностью в 2 и 20 Тфлоп не будут существенно различаться. Но более мощная система потребует более сложной схемы охлаждения, скорее всего жидкостной. А это автоматически влечёт за собой проведение дорогостоящих и длительных работ по подготовке помещений. Да и электроэнергии в процессе эксплуатации мощная система потреблять будет больше.

Есть и проблемы, связанные со спецификой сферы высокопроизводительных вычислений. ПО, написанное еще для больших и мини-машин или ПК, скорее всего будет требовать довольно радикальной переработки. Частично эта тема отражена в интервью с Борисом Тоботрасом, начальником ВЦ НИИ радио. И он предупреждает, что этот процесс может занять довольно длительное время.

И все же несмотря на перечисленные выше проблемы суперкомпьютеры в российских компаниях будут создаваться все активнее. Это магистральный путь развития, и от этого никуда не деться. Тем более, что необходимость движения в эту сторону осознана уже многими компаниями. Ну а решение имеющихся проблем и сложностей — дело времени.

Использовать стандартные архитектуры и блейд-системы

Евгений Лагунцов

Системный архитектор, «НР Россия»Стратегия HP при построении высокопроизводительных вычислительных комплексов базируется на использовании индустриально‑стандартных процессорных архитектур, что позволяет сократить стоимость систем, гарантировать совместимость и переносимость программных средств, а также высокую производительность и возможность развития экосистемы разработчиков и пользователей программного обеспечения, производителей аппаратных и системных средств.

В качестве платформы для построения вычислительных комплексов доминирующее место занимают блейд‑системы, имеющие заметные преимущества перед традиционными продуктами, среди которых можно назвать компактность, существенно меньшее энергопотребление, более эффективный теплоотвод, интегрированные средства сетевых коммуникаций, значительно меньшее количество кабелей, лучшую управляемость, легкость в обслуживании и простую линейную масштабируемость от нескольких узлов до нескольких тысяч.

Возможности аппаратного обеспечения растут с каждым годом; растет и сложность задач, решаемых на вычислительных комплексах. Важнейшим элементом развития и полномасштабного внедрения технологий высокопроизводительных вычислений в российскую науку и промышленность являются экспертиза, знания и умения отечественных программистов и исследователей. Анонсированная HP совместно с МСЦ РАН и ИСП РАН программа «Университетский кластер» направлена на повышение уровня проникновения технологий высокопроизводительных вычислений в образовательную среду, повышение качества подготовки специалистов и развитие экосистемы пользователей высокопроизводительных технологий.